![图片[1]-【ai精翻】使用 Qwen 2.5 和 Ollama 进行 AI 开发:本地构建 AI 应用程序-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2025/05/image-53-600x338.png)

您将学到什么

- 使用 Ollama 在本地机器上设置并运行 Qwen 2.5

- 了解大型语言模型 (LLM) 的工作原理

- 使用 Python 和 FastAPI 构建 AI 驱动的应用程序

- 创建 REST API 以在本地与 AI 模型进行交互

- 使用 React.js 将 AI 模型集成到 Web 应用程序中

- 优化和微调 AI 模型以获得更好的性能

- 实施无需依赖云的本地 AI 解决方案

- 使用 Ollama CLI 和 Python SDK 管理 AI 模型

- 在本地和云平台上部署AI应用程序

- 探索聊天机器人以外的真实 AI 用例

要求

- 基本的 Python 知识(变量、函数和循环) – 如果您不具备 – 我们将介绍基本的 Python

- 熟悉 API(REST API、JSON 数据处理)

- 基本命令行技能(运行脚本、安装包)

- 一台装有 macOS、Windows 或 Linux 的计算机(用于本地 AI 设置)

- 互联网连接(用于下载 Qwen 2.5 和依赖项)

- 可选:JavaScript/React 基础知识(用于 UI 开发)

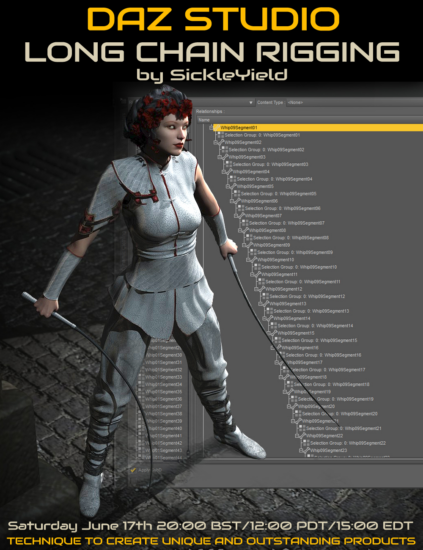

描述

您准备好在不依赖基于云的 API 的情况下在本地构建 AI 驱动的应用程序了吗?本实践课程将教您如何使用Qwen 2.5和Ollama (两个用于在本地机器上运行大型语言模型 (LLM) 的强大工具)开发、优化和部署 AI 应用程序。

随着开源人工智能模型的兴起,开发人员现在有机会创建处理文本、生成内容和自动执行任务的智能应用程序,同时保证数据的私密性和安全性。在本课程中,您将学习如何安装、配置和集成 Qwen 2.5 与 Ollama,构建基于 FastAPI 的 AI 后端,以及开发真实世界的 AI 解决方案。

为什么要学习 Qwen 2.5 和 Ollama?

Qwen 2.5是阿里云开发的强大的大型语言模型(LLM),针对自然语言处理(NLP)、文本生成、推理和代码辅助进行了优化。与GPT-4等传统的基于云的模型不同,Qwen 2.5可以在本地运行,这使其成为隐私敏感的 AI 应用程序的理想选择。

Ollama是一款AI 模型管理工具,允许开发人员在本地高效、低延迟地运行和部署 LLM。使用 Ollama,您可以提取模型,在应用程序中运行它们,并针对特定任务对其进行微调——所有这些都不需要昂贵的云资源。

本课程实用且注重实践,旨在帮助您在实际项目中应用人工智能。无论您想构建人工智能聊天界面、文档摘要器、代码助手还是智能自动化工具,本课程都将为您提供必要的技能。

为什么要参加这门课程?

-通过实际项目进行 AI 开发–不依赖云 API —保证您的 AI 应用程序的私密性和安全性-使用开源 LLM 的未来技能-使用Ollama 的本地执行进行快速、高效的 AI 部署

在本课程结束时,您将在您的机器上运行由人工智能驱动的应用程序,深入了解 LLM ,并掌握开发未来人工智能解决方案的技能。您准备好开始建造了吗?

本课程适合哪些人?

- Python 开发人员希望将 AI 集成到他们的项目中

- 想要构建基于 LLM 的应用程序的软件工程师

- 渴望学习实践 AI 开发的 AI/ML 初学者

- 希望将 AI 与 Web 应用程序集成的全栈开发人员

- 科技企业家探索人工智能解决方案

- 对本地 AI 模型执行感兴趣的学生和研究人员

![[完结·Ai精翻&中文朗读] Blender北欧小姐姐动画-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2024/06/微信图片_20240628145821-800x490.png)

![[包更新]Cinema4d动效-Msedov会员频道(已更到25年5月)-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2022/11/000-691x550.jpg)

![[包更新]cinema4d动效-Vincent Schwenk(更到25年5月)-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2022/11/Snipaste_2025-06-02_09-40-28-528x550.jpg)

![[Ai精翻] Romain Guillon会员频道 [作者目前已停更,已更到24年5月]-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2022/11/Hair-secret-rendering-800x450.jpg)

![[包更新]Cinema4d动力学-3dbonfire(已更到25年3月)-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2022/11/5ab4e1768c9530e29f1fd78121a0e11-550x550.jpg)

![[包更新]Redshift产品渲染-Ross Mason会员频道 (已更到25年5月)-土狗cg资源站](https://www.cgltgcg.com/wp-content/uploads/2022/11/000000-619x550.jpg)

请登录后查看评论内容